Il y a quelques jours, Elon Musk tweetait qu’il fallait faire très attention avec l’intelligence artificielle, une technologie qu’il qualifiait de «potentiellement plus dangereuse que la bombe atomique». Et il n’est pas le seul à se méfier de l’émergence éventuelle de SkyNet ou de la Matrice, loin de là.

L’intelligence artificielle, si jamais elle devait se transformer en menace dans un futur lointain, ne pourrait pas constituer un plus grave danger pour l’être humain que ce que l’être humain lui-même représente dès maintenant.

En mai dernier, dans le journal britannique The Independent, on pouvait lire que la création d’une intelligence artificielle serait «l’événement le plus marquant de l’histoire de l’humanité» mais que «malheureusement, cela pourrait aussi être le dernier».

Il s’agit d’une lettre notamment cosignée par le célébrissime Stephen Hawking, par le physicien nobélisé Frank Wilczek et même par l’informaticien Stuart Russell (coauteur avec Peter Norvig de Google de la bible du domaine, Artificial Intelligence : A Modern Approach).

Pourquoi? Parce que, si les bénéfices potentiels de l’intelligence artificielle sont immenses, les risques le sont encore plus. Les coauteurs souscrivent notamment à la théorie de la singularité, selon laquelle une machine suffisamment intelligente pourrait créer son propre successeur encore plus puissant, ce qui, après quelques générations, rendrait l’intelligence artificielle incommensurablement plus avancée que nous et totalement incompréhensible.

«Si l’impact à court terme de l’intelligence artificielle dépend de celui qui la contrôle, son impact à long terme dépend plutôt de savoir si quelqu’un pourra la contrôler, point», peut-on également lire dans le même texte.

Le mythe de Frankenstein revisité

La peur de voir nos créations se retourner contre nous n’a rien de nouveau. Le mot «robot» a été introduit dans le langage courant par une pièce de théâtre qui date de 1920 et dans laquelle une révolte de robots-esclaves entraîne l’extermination des êtres humains. Frankenstein, un siècle plus tôt, relevait de la même influence. Même certaines versions des légendes médiévales du Golem, un être formé de terre glaise et animé par magie pour protéger son maître, affirment que le monstre pouvait devenir violent et incontrôlable.

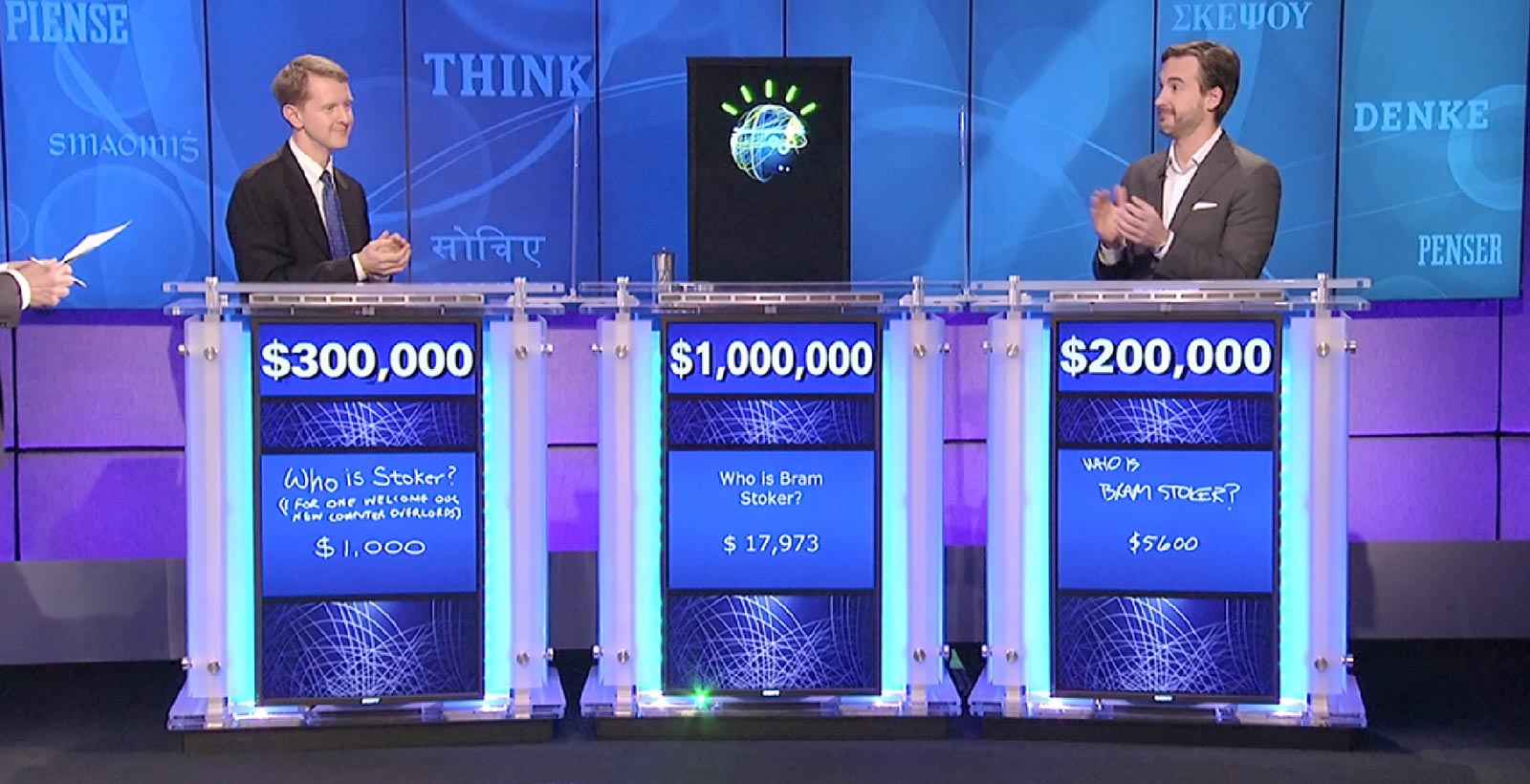

Il y a plus de 50 ans, Isaac Asimov a réfuté le mythe de Frankenstein en inventant ses fameuses «trois lois de la robotique» qui reposent sur un principe bien simple : un robot (ou une intelligence artificielle) est un outil, et un outil suit les instructions qu’on lui donne. Jusqu’ici, c’est Asimov qui a raison. Ni Deep Blue lorsqu’il a affronté le champion d’échecs Garry Kasparov, ni Watson sur le plateau de Jeopardy n’ont soudainement décidé d’assassiner leurs adversaires. Ils ont fait ce qu’on leur a dit de faire – très bien, mieux que quiconque en fait, mais c’est tout.

Mais la vraie intelligence artificielle, elle?

«Oui, mais Deep Blue et Watson sont certes des machines ultrarapides, mais elles ne sont pas vraiment intelligentes», me direz-vous. «Qu’arrivera-t-il quand un ordinateur développera la cognition, la conscience de sa propre existence?»

Eh bien, à ce moment-là, si jamais cela arrive (et nous en sommes encore très loin), nous serons aux prises avec deux systèmes intelligents que nous ne comprenons pas : l’intelligence artificielle… et le cerveau humain.

C’est pour cela que je crois que la méfiance des illustres personnages cités au début de cet article est injustifiée : l’intelligence artificielle, si jamais elle devait se transformer en menace dans un futur lointain, ne pourrait pas constituer un plus grave danger pour l’être humain que ce que l’être humain lui-même représente dès maintenant.

Si jamais un ordinateur devait un jour développer une maladie cybermentale aussi dangereuse que l’ultranationalisme ou le fanatisme religieux, je suis tenté de dire qu’on n’aurait qu’à le pirater ou attendre qu’il s’effondre de lui-même sous le poids de ses bogues.

Un supercalculateur transcendant pourrait-il nous considérer comme des êtres inférieurs et nous traiter comme des rats de laboratoire? En 2012, Facebook a expérimenté sur le moral de ses utilisateurs en manipulant leur fil d’actualité pour leur montrer un nombre anormalement élevé de nouvelles tristes ou joyeuses. De son côté, OkCupid ment à ses clients en suggérant des rencontres avec des gens avec qui ils n’ont rien en commun. Dans les deux cas, on voulait simplement «voir ce qui se passerait». Il y a sûrement d’autres exemples.

Un ordinateur conscient deviendrait-il trop puissant pour qu’on puisse le débrancher s’il détraque et se met à causer du tort à l’humanité entière? Les grandes banques de Wall Street ont détruit l’économie mondiale en 2008 et elles ont été récompensées à grands coups de milliards.

Et si jamais un ordinateur devait un jour développer une maladie cybermentale aussi dangereuse que l’ultranationalisme ou le fanatisme religieux, je suis tenté de dire qu’on n’aurait qu’à le pirater ou attendre qu’il s’effondre de lui-même sous le poids de ses bogues. Après tout, son logiciel aura bien été programmé par quelqu’un, et lorsqu’on considère la qualité moyenne des logiciels actuellement en service…

La vraie menace

Hawking, Musk et leurs acolytes affirment qu’il faut développer l’intelligence artificielle pour profiter de ses bénéfices, mais étudier ses conséquences avec soin pour éviter d’éventuelles catastrophes. Soit. Mais je crois que les bénéfices l’emportent.

On peut déjà accomplir un million de choses très utiles en simulant des processus de décision intelligents ou en laissant ceux-ci émerger d’eux-mêmes dans nos logiciels. Par exemple, j’ai déjà développé des algorithmes génétiques qui «découvrent» des solutions à des problèmes par sélection plus ou moins naturelle. La reconnaissance vocale est déjà à des années-lumière de ce qu’elle était lorsque j’ai brièvement travaillé dans le domaine, il y a une quinzaine d’années. Google, c’est aussi une forme d’intelligence artificielle douce. Tout comme les jeux vidéo, les recommandations de Netflix et d’Amazon, etc.

Pendant ce temps, on ne signale pas l’ombre d’une menace liée à l’intelligence artificielle, hormis certains systèmes de transactions financières automatisées et certains projets d’armes autonomes qui, lorsqu’ils causent du tort, le font exactement de la manière prévue par leurs programmeurs.

Autrement dit : c’est de l’intelligence naturelle qu’on ferait mieux de se méfier.