C’est le défi qu’à décider de relever la compagnie Lytro avec le son système Immerge.

Une scène comme si vous y étiez

Le temps des vidéos captées en mode 360 degrés avec des couronnes de caméras grand angle accrochées les unes aux autres sera bientôt révolu. L’entreprise californienne Lytro travaille désormais depuis plus de 8 ans au développement d’une technologie très ambitieuse dont le mandat est de réussir à recréer des scènes réelles ou virtuelles dans lesquels le spectateur peut se déplacer sur 6 axes de liberté (haut, bas, droite, gauche, avant, arrière).

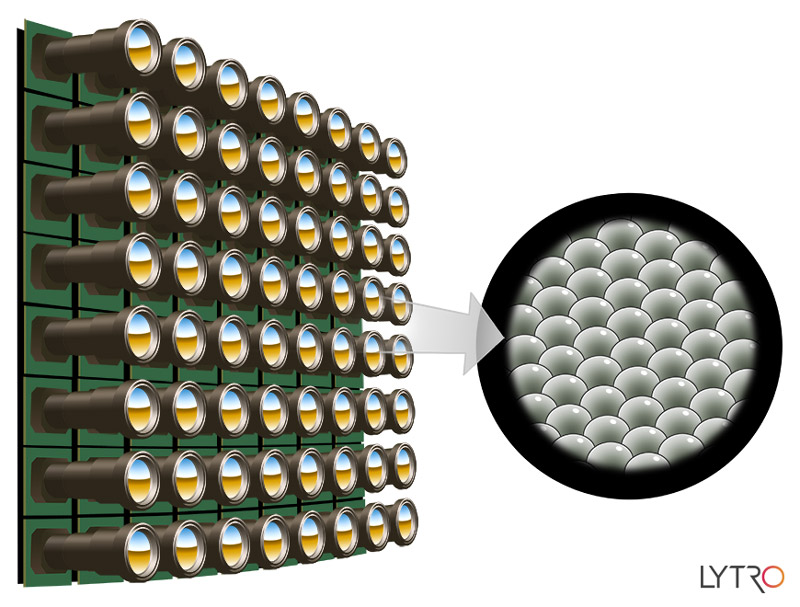

La technologie utilisée pour atteindre cet objectif est la capture des champs lumineux. L’entreprise avait lancé il y a 3 ans le premier appareil photo à utiliser ce procédé, aussi connu sous le nom de photographie plénoptique, la caméra Lytro Light Field.

En gros, c’est un appareil numérique doté d’un capteur formé d’une matrice de micro-objectifs saisissant en plus des rayons lumineux, leur angle d’incidence et de réflexion. Le but? Enregistrer toutes les informations visibles d’un champ lumineux lorsqu’il traverse une scène. Cela permet notamment de capter un environnement en ayant un focus total dans toutes les directions pour une mise au point ultérieure par post-traitement. Plus la peine donc d’avoir une multitude de caméras captant des images nettes de tous les objets pouvant nécessiter un focus pour les spectateurs.

Plus la peine de faire de la couture en postproduction

En plus d’enregistrer les rayons lumineux et leurs angles, le système Immerge détecte aussi la distance qu’ils parcourent depuis le moment où ils sont captés jusqu’à la caméra.

Un des principaux désavantages des images capées à 360 degrés à l’ancienne, est que chaque image devait être cousue avec les autres afin d’offrir la globalité de la scène au spectateur une fois la scène tournée. Grâce à la technologie de Lytro, c’est désormais inutile.

En plus d’enregistrer les rayons lumineux, leurs angles de perception et de réflexion, le système Immerge détecte aussi la distance qu’ils parcourent depuis le moment où ils sont captés jusqu’à la caméra. Ainsi, les opérateurs peuvent recréer une scène aussi facilement qu’ils la captent, en permettant d’évaluer la position de chacun des objets présents dans la scène qu’ils soient réels ou virtuels.

Du virtuel au réel en un bouton et vice-versa

Le dernier défi qu’essaie de relever la startup américaine et de rendre encore plus floue la frontière entre le virtuel et le réel. L’inclusion d’objets virtuels dans une scène réelle pose toujours des problèmes et implique des coûts élevés pour chaque scène. Grâce à cette technologie, plus la peine de calculer l’angle d’éclairage, la distance, le focus etc. reliés à l’objet puisqu’il suffit alors d’appliquer les valeurs captées par la caméra à cet endroit dans la scène pour un réalisme total.

Évidemment, l’entreprise a rapidement compris qu’un autre défi technologique se présentait à eux : l’enregistrement en temps réel d’une énorme quantité de données. Elle s’est donc aussi attaquée à ce problème en offrant un serveur dédié au stockage ultra rapide, le Lytro Image Server, ainsi qu’une suite d’outils d’édition afin de traiter et manipuler intuitivement et facilement les données ainsi capturées.

Compatible avec la plupart des casques de Réalité Virtuelle d’ores et déjà annoncés, aucun prix n’a encore été communiqué pour cette «caméra 2.0», mais la technologie permettrait, courant 2016, à un plus grand nombre de créateurs de produire à moindre coût des contenus jusque là réservés aux très riches studios d’Hollywood.